基于 Diffusion 的 3D 生成方式!

[2303.05371] 3DGen: Triplane Latent Diffusion for Textured Mesh Generation(2023 年 3 月)

干了啥?

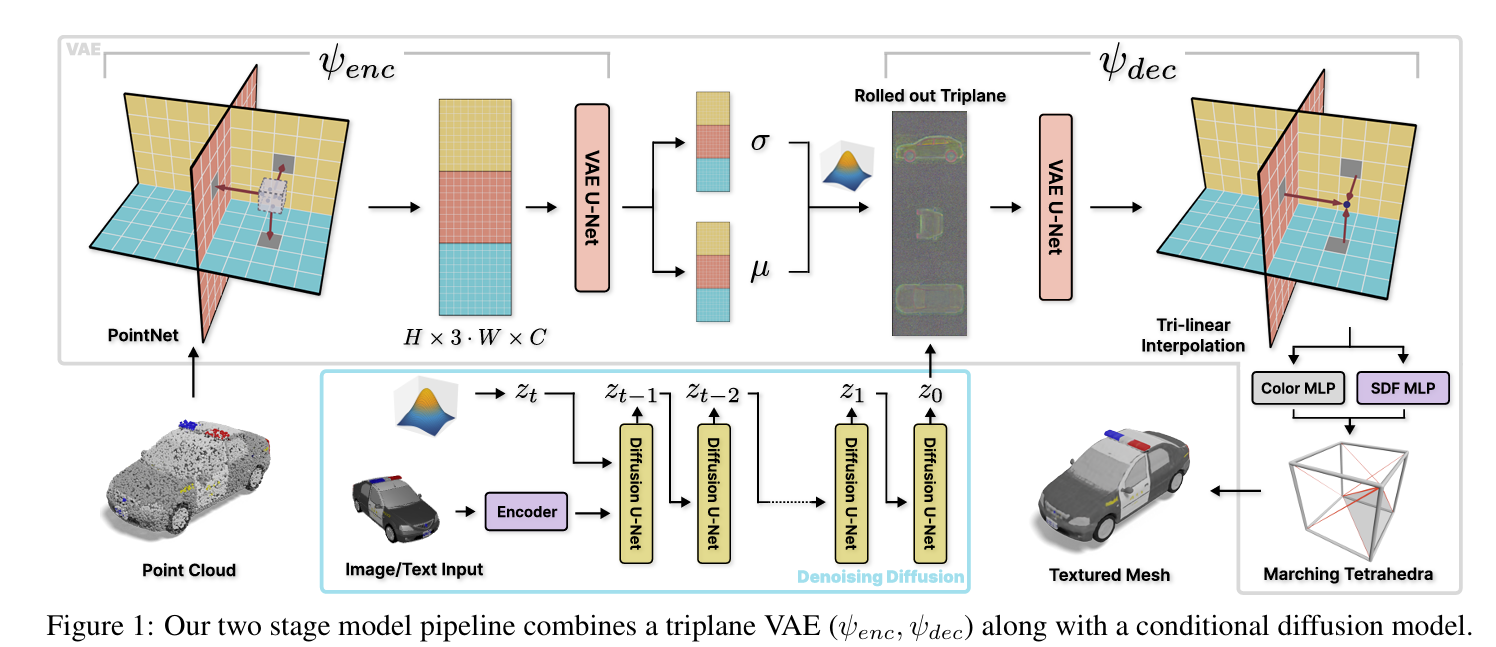

3DGen 与其说创新,更像是一个对前人工作的组合。包含以下要素:

- 用 Triplane 作为 3D 模型的隐式表示;

- 训练一个 VAE,其

- Encoder 把输入的点云变成 Triplane 特征;

- Decoder 把 Triplane 变成 Mesh,方法是对空间中每个格点查询特征,利用 DmTet 转化为 Mesh;

- 训练一个 Diffusion 模型,基于输入的条件把随机 Gaussian 噪声变为指定 Triplane。

此外还可以让生成的物体带纹理,方法是训练 VAE 的时候让点云带颜色信息,然后类似训练 Diffusion 模型。

可以看出这就像是一个 3D 版本的 LDM(Stable Diffusion)。

论文方法就 1 页不到。剩下全是实验和各种细节了。据说可以单卡跑生成。到时候试试。

TODO

声明:

本文采用

BY-NC-SA

协议进行授权,如无注明均为原创,转载请注明转自

大仓库

本文地址: 笔记 – 3DGen – Triplane Latent Diffusion for Textured Mesh Generation

本文地址: 笔记 – 3DGen – Triplane Latent Diffusion for Textured Mesh Generation

评论功能没修好,暂不开放